Si tienes un negocio, la visibilidad es clave para el éxito de un sitio web. Es aquí donde robots.txt juega un papel crucial. Este archivo indica a los robots de los motores de búsqueda qué partes de un sitio pueden ser procesadas o ignoradas. Sin embargo, hay que tener claro que su uso incorrecto puede conducir a resultados indeseados.

Algo que quiero dejar muy claro, es que el robots.txt no se debe usar para gestionar la indexación, eso es un error muy común y que en la mayoría de casos solo da problemas.

¿Qué es el archivo Robots.txt?

Robots.txt es un archivo de texto plano que se coloca en la raíz de un sitio web para comunicarse con los bots de búsqueda (por ejemplo el Googlebot para smartphones) y lo que hace es indicar qué áreas del sitio están restringidas y cuáles están disponibles para ser rastreadas.

Para utilizarlo correctamente es esencial conocer los principales comandos que se utilizan en él, un poquito más adelante en este post te los explico todos.

¿Por qué es importante el archivo Robots.txt?

El archivo robots.txt actúa como una guía para los motores de búsqueda (y además es el primer archivo que buscan los bots cuando llegan a una web), permitiéndoles saber qué partes de tu sitio web deben o no deben rastrear.

Su función principal es establecer reglas que regulan el comportamiento de los bots cuando visitan un sitio y aunque su uso es opcional, su implementación adecuada puede influir significativamente en la visibilidad, eficiencia y seguridad del sitio web.

Además, los motores de búsqueda como Google, Bing y otros, respetan (en su mayoría) las directrices establecidas en el archivo robots.txt. Esto permite establecer una comunicación clara sobre las intenciones del propietario del sitio, mejorando la eficiencia en la recopilación de datos y la gestión del contenido.

Los bots tienen un límite de tiempo y recursos asignados para rastrear contenido, conocido como presupuesto de rastreo. El archivo robots.txt permite definir qué áreas deben recibir prioridad y qué partes no son relevantes para la estrategia de SEO, evitando desperdiciar recursos. En webs muy grandes, trabajar el robots.txt bien puede suponer una gran diferencia.

¿Cómo ver el robots.txt de una web?

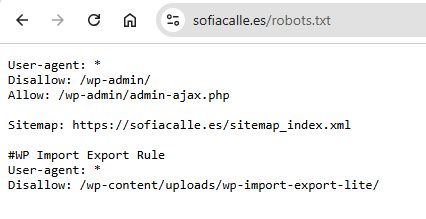

Para ver el archivo robots.txt de un sitio web, simplemente añade ‘/robots.txt’ al final de la URL del dominio en tu navegador. Esto te permitirá ver las directivas que el administrador del sitio ha establecido para los bots de búsqueda.

Por ejemplo, para ver el archivo de ‘sofiacalle.es’, deberías ir a ‘https://www.sofiacalle.es/robots.txt’.

¿Cuáles son las reglas básicas para un archivo robots.txt?

Cuando un motor de búsqueda visita un sitio web, lo primero que hace es buscar el archivo robots.txt. Este paso es crucial para definir las pautas que el rastreador debe seguir mientras navega por el sitio. por eso es importante que te familiarices con lo que en él aparece.

Para redactar las reglas básicas de un robots.txt de manera correcta, debemos entender los comandos o directivas que lo componen y algunos extras que nos vendrán bien.

- User-agent: Define a cuál motor de búsqueda va dirigida una serie de instrucciones. Se puede especificar un bot en particular o usar

*para aplicar a todos los bots.

EjemploUser-agent: * - Disallow: Especifica las URLs que no deben ser rastreadas.

EjemploUser-agent: Disallow: /admin(prohíbe el acceso a la carpeta /admin). - Allow: Permite, en circunstancias específicas, el rastreo de cierta subdirectorio, incluso dentro de un directorio con restricción global.

EjemploUser-agent: Allow: /admin/public(permite este subdirectorio aunque /admin esté bloqueado). - Sitemap: Facilita el acceso a los motores de búsqueda que lo soportan indicando la localización del mapa del sitio.

Ejemplo

Sitemap: https://www.ejemplo.com/sitemap.xml - Crawl-delay (opcional): Define el tiempo de espera entre solicitudes del bot (OJO no es compatible con Googlebot).

EjemploCrawl-delay: 10(espera de 10 segundos). - #: lo usamos para hacer anotaciones

Ejemplo

#esto es un comentario cualquiera, no una regla - *: lo usamos para decir que queremos que se aplique a todo

EjemploUser-agent: *

Es importante tener en cuenta que las reglas deben ser claras y directas, ya que los errores pueden provocar que contenido valioso quede fuera del alcance de los rastreadores.

Errores comunes en Robots.txt

Hay elementos clave que no se deben bloquear en un archivo robots.txt para evitar problemas de indexación y visibilidad en los motores de búsqueda. Estos son algunos ejemplos:

1. Bloquear archivos CSS y JS: Los motores de búsqueda, como Google, necesitan acceder a archivos de hojas de estilo y scripts para renderizar correctamente el sitio web. Si estos archivos están bloqueados, la página podría parecer rota o mal diseñada.

Un ejemplo de error común es bloquear toda la carpeta /wp-admin/, deberíamos permitir acceder al menos al admin-ajax (Este archivo es usado por el sistema de WordPress y ciertos plugins para ejecutar scripts en la parte visible de la web (el frontend) como formularios, filtros dinámicos, etc.).

2. Poner disallow a páginas públicas importantes: bloquear secciones como páginas de servicios, productos o categorías importantes puede afectar el SEO, ya que los motores de búsqueda no podrán rastrearlas.

3. No añadir o bloquear el Sitemap.xml: el archivo sitemap.xml es esencial para que los bots encuentren y rastreen páginas importantes del sitio. Si se bloquea, se pierde esa guía para el rastreo.

4. Bloquear imágenes importantes (en e-commerce por ejemplo): bloquear imágenes evita que aparezcan en la búsqueda de imágenes de Google, lo que puede afectar el tráfico.

5. Uso excesivo de Disallow: bloquear demasiadas partes del sitio, lo que puede evitar que los motores de búsqueda indexen contenido importante.

Por ejemplo: Disallow: / – bloquearía todo el sitio, ¿quieres que tu web desaparezca de internet? entonces aquí tienes tu solución.

6. Usar reglas redundantes: crear reglas innecesarias o repetitivas que compliquen la gestión del archivo.

Por ejemplo:

User-agent: Googlebot

Disallow: /private/

User-agent: *

Disallow: /private/

Aquí lo mejor sería usar directamente el * para permitir el acceso a todos los bots y luego si el disallow, dar acceso a Googlebot y luego a todos es redundante y solo complica el documento.

7. No tener un archivo robots.txt cuando es necesario: no incluir un archivo robots.txt en sitios grandes o complejos, dejando que los bots rastreen todo, lo que puede desperdiciar su presupuesto de rastreo (crawl budget).

Bloquea únicamente directorios sensibles (como /admin, /private, /login, etc.) o archivos que no deban aparecer en los motores de búsqueda. Un error común es bloquear por exceso, lo que puede afectar gravemente la visibilidad del sitio.

Es vital que no uses tu archivo robots.txt para controlar la indexación (me explico):

El archivo robots.txt no es una directiva de indexación, por lo que bloquear el rastreo de una URL en este archivo no garantiza que esa URL no aparezca en los resultados de búsqueda. Si Google descubre la URL desde otra fuente (como enlaces externos), puede indexarla aunque no pueda rastrear su contenido.

Además, si una página está bloqueada por robots.txt pero es indexada, Google puede mostrar la URL en los resultados con un título genérico o vacío, y sin descripción.

Por ejemplo: imagina que uso disallow para que no se indexe la página sofiacalle.es/blog, esto impedirá que los bots accedan a /blog/, pero si Google encuentra la URL en un enlace externo, podría indexarla y mostrar algo así: Sin descripción disponible debido a la restricción en el archivo robots.txt.

Y JAMÁS PODRÁS DESINDEXARLA PUES GOOGLE NO PUEDE ACCEDER A ELLA PARA CAMBIAR SU ESTADO PUES LA TIENES BLOQUEADA POR ROBOTS.TXT

El archivo robots.txt por defecto

Si usas WordPress, lo normal es que tengas un archivo básico como el que te muestro a continuación .

Si tu web es pequeñita, o muy básica, por norma general este robots.txt te servirá y no tendrás que tocar nada.

En este caso, por ejemplo estoy dando acceso (con el * en user agent) a todos los bots (google, bing, etc).

Además, estoy bloqueando el acceso a los bots (con disallow) al directorio /wp-admin/, que contiene los archivos administrativos del backend de WordPress. Esto es importante para evitar que los motores de búsqueda rastreen páginas internas o de administración que no son relevantes para los usuarios.

Y luego, estoy permitiendo el acceso al archivo admin-ajax.php dentro de /wp-admin/ (con allow). Este archivo es necesario para que ciertas funcionalidades del frontend funcionen correctamente (como formularios, elementos interactivos, o actualizaciones dinámicas).

Luego puede pasar como en este caso que he añadido un plugin, que el propio plugin añada reglas específicas, como en el caso del comentario (con #) WP Import Export que ha bloqueado al rastreo todo lo subido a la carpeta uploads del propio plugin.

Y luego por ahí en medio tenemos mi sitemap (que en este caso es el índice del sitemap construido con Rank Math, automáticamente)

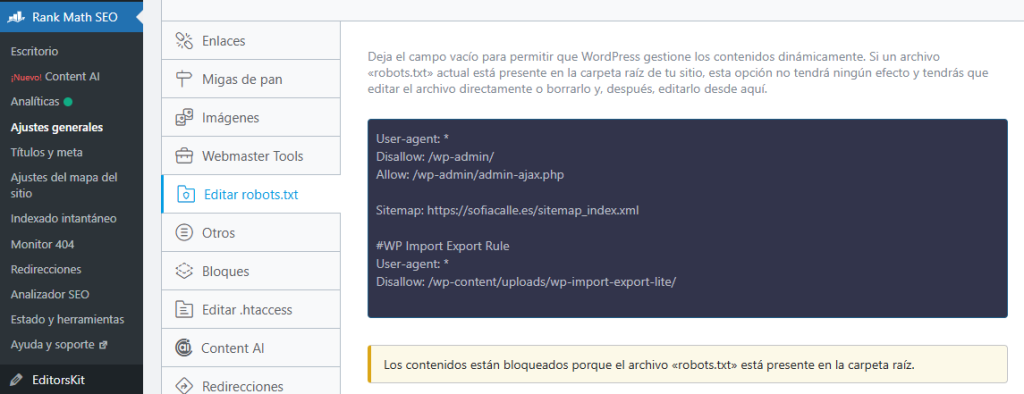

El archivo robots.txt en WordPress no depende directamente de un plugin de SEO, pero puede ser gestionado por algunos de ellos, como Yoast SEO, Rank Math, o All in One SEO. Estos plugins permiten modificar el contenido del archivo sin tener que acceder a los archivos del servidor.

Te recomiendo que si no sabes nada de SEO no toquetees nada, que la puedes liar.

¿Cómo crear un archivo Robots.txt?

Crear un archivo robots.txt eficiente requiere de atención a los detalles para asegurar una correcta implementación. A continuación, te detallo los pasos esenciales para su creación sin plugins:

- Identifica las secciones: antes de modificar o crear un archivo, identifica las secciones del sitio que deben o no ser rastreadas.

- Edita el archivo: usando un editor de texto simple (como Notepad), establece las directivas y los comandos necesarios para controlar el acceso.

- Súbelo al servidor: guarda y coloca el archivo en el directorio raíz del servidor. Puedes hacerlo por medio de FTP usando Filezilla, por ejemplo.

Si usas plugins SEO puedes buscar la opción en la administración del propio plugin.

En Rank Math por ejemplo basta con ir a ajustes generales y luego buscar la opción de edición del robots (debes tener activa la opción de modo avanzado en el escritorio del plugin)

Ojo que si te fijas, hay una nota que pone que los contenidos están bloqueados porque hay un archivo en la carpeta raíz, esto significa que si quieres cambiar algo del archivo aquí, antes debes borrar el documento de la raíz de tu sitio, pues ese es el que manda.

¿Cómo probar el funcionamiento de mi archivo Robots.txt?

Pobar el archivo robots.txt antes de asumir que está funcionando como se espera es importante para asegurarte de que estás permitiendo el rastreo de lo que te interesa y bloqueando aquello que no quieres que Google siga. Herramientas como Google Search Console ofrecen la posibilidad de probar y validar las reglas definidas en tu archivo, mostrando qué URLs están bloqueadas y cuáles no según las directivas establecidas.

Google Search Console

Google ofrece una herramienta gratuita que te permite analizar y probar tu archivo robots.txt directamente desde tu cuenta de Search Console y además tiene una ventaja, que es que te muestra cómo Googlebot interpreta las reglas.

- Accede a Google Search Console.

- Selecciona tu propiedad (sitio web).

- Dirígete a la sección de “ajustes” y luego ve a robots, abre tu informe y a analizar como loc@.

Optimiza el Rastreo de tu Sitio con un Archivo Robots.txt Bien Configurado

Un archivo robots.txt correctamente configurado puede marcar la diferencia en la visibilidad y el rendimiento de tu sitio web. Al establecer directrices claras para los bots, puedes priorizar contenido relevante, ahorrar presupuesto de rastreo y evitar errores comunes como el bloqueo de archivos CSS, JS o imágenes importantes. Aprovecha herramientas como Google Search Console para verificar su funcionamiento y recuerda que el archivo robots.txt no controla la indexación. Para seguir mejorando tu SEO, visita nuestro post sobre meta etiquetas esenciales para SEO.